Descubre la desviación estándar: raíz cuadrada de la varianza

En el mundo de las estadísticas y la probabilidad, la desviación estándar es uno de los conceptos más importantes. Se utiliza para medir la dispersión o variabilidad de un conjunto de datos. La desviación estándar es la raíz cuadrada de la varianza y es una medida de la distancia promedio de cada punto de datos con respecto a la media.

Para entender mejor la desviación estándar, primero debemos entender la varianza. La varianza es una medida de qué tan dispersos están los datos en relación con la media. Se calcula encontrando la diferencia entre cada punto de datos y la media, elevándolo al cuadrado y sumando todos los resultados. Luego se divide entre el número total de puntos de datos para obtener la varianza.

Una vez que se tiene la varianza, se puede calcular la desviación estándar tomando la raíz cuadrada de la varianza. La desviación estándar nos dice qué tan lejos están los datos de la media en términos de la desviación típica. Si la desviación estándar es grande, esto indica que los datos están muy dispersos y no se agrupan cerca de la media. Si la desviación estándar es pequeña, indica que los datos están agrupados cerca de la media.

La desviación estándar se utiliza en una variedad de campos, desde las finanzas hasta la ciencia. En finanzas, se utiliza para medir la volatilidad de los precios de las acciones. En ciencia, se utiliza para medir la variabilidad de los datos experimentales. También se utiliza en la psicología para medir la variabilidad en los resultados de las pruebas.

La desviación estándar también es importante en la toma de decisiones. Cuando se conoce la desviación estándar de un conjunto de datos, se puede calcular un intervalo de confianza alrededor de la media. Esto significa que se puede estar seguro de que un cierto porcentaje de los datos caerán dentro de ese intervalo, lo que ayuda a tomar decisiones más informadas.

La desviación estándar es una medida importante de la dispersión o variabilidad de un conjunto de datos. Es la raíz cuadrada de la varianza y nos dice qué tan lejos están los datos de la media en términos de la desviación típica. Se utiliza en una variedad de campos y también es importante en la toma de decisiones.

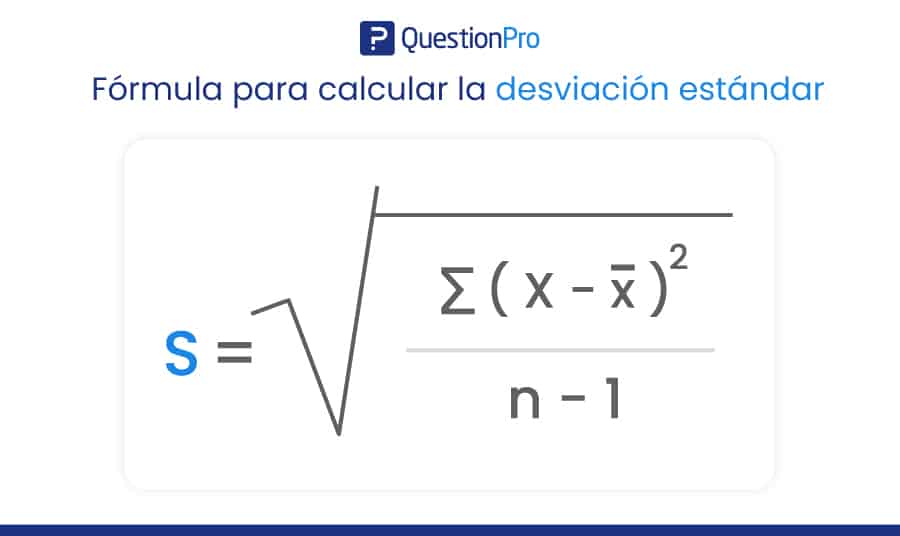

Cómo calcular la desviación estándar

Calcular la desviación estándar es relativamente fácil si se tiene la varianza. Para calcular la desviación estándar, simplemente tome la raíz cuadrada de la varianza.

Aquí hay un ejemplo:

Supongamos que tenemos los siguientes datos: 3, 7, 11, 15, 19.

Primero, calculamos la media de los datos:

(3 + 7 + 11 + 15 + 19) / 5 = 11

Luego, calculamos la varianza:

((3-11)^2 + (7-11)^2 + (11-11)^2 + (15-11)^2 + (19-11)^2) / 5 = 32

Finalmente, tomamos la raíz cuadrada de la varianza para obtener la desviación estándar:

√32 ≈ 5.66

Por lo tanto, la desviación estándar de los datos es de aproximadamente 5.66.

Interpretación de la desviación estándar

La desviación estándar se puede interpretar como la distancia promedio de cada punto de datos con respecto a la media. Esto significa que cuanto mayor sea la desviación estándar, más dispersos estarán los datos. Si la desviación estándar es pequeña, esto indica que los datos están agrupados cerca de la media.

Por ejemplo, si la desviación estándar de un conjunto de datos es 1, esto significa que la mayoría de los puntos de datos están a una distancia de 1 de la media. Si la desviación estándar es 5, esto significa que los puntos de datos están más dispersos y algunos pueden estar a una distancia de 5 o más de la media.

Usando la desviación estándar para la toma de decisiones

La desviación estándar es importante en la toma de decisiones porque permite calcular un intervalo de confianza alrededor de la media. Un intervalo de confianza es un rango de valores en el que se puede estar seguro de que un cierto porcentaje de los datos caerán.

Por ejemplo, si se sabe que la media de un conjunto de datos es de 100 y la desviación estándar es de 10, se puede calcular un intervalo de confianza del 95% alrededor de la media. Esto significa que se puede estar seguro de que el 95% de los datos caerán dentro del rango de 80 a 120.

Usar un intervalo de confianza es importante en la toma de decisiones porque ayuda a reducir la incertidumbre. Si se tiene un intervalo de confianza estrecho, se puede estar más seguro de que los datos son precisos y se pueden tomar decisiones más informadas.

Desviación estándar vs. varianza

La desviación estándar y la varianza están estrechamente relacionadas, pero son medidas diferentes de la variabilidad de los datos. La varianza es la media de las diferencias al cuadrado entre cada punto de datos y la media. La desviación estándar es simplemente la raíz cuadrada de la varianza.

La principal diferencia entre la desviación estándar y la varianza es que la desviación estándar se expresa en las mismas unidades que los datos, mientras que la varianza se expresa en unidades al cuadrado. Esto significa que la desviación estándar es más fácil de interpretar que la varianza.

Desviación estándar y distribuciones normales

La distribución normal es una distribución de probabilidad que se utiliza con frecuencia en estadística y probabilidad. Se caracteriza por tener una forma de campana y una media y desviación estándar conocidas.

La desviación estándar es importante en la distribución normal porque se utiliza para determinar la probabilidad de que un punto de datos caiga dentro de un cierto rango. Por ejemplo, si se sabe que la media de una distribución normal es de 100 y la desviación estándar es de 10, se puede determinar la probabilidad de que un punto de datos caiga dentro de un rango específico.

Por ejemplo, se puede determinar la probabilidad de que un punto de datos caiga dentro de un rango de 90 a 110 utilizando la distribución normal y la desviación estándar conocida.

Desviación estándar y regresión lineal

La regresión lineal es un método utilizado para encontrar la relación entre dos variables. Se utiliza con frecuencia en estadística y ciencia de datos para predecir valores futuros de una variable en función de otra variable.

La desviación estándar es importante en la regresión lineal porque se utiliza para calcular el error estándar de la estimación. El error estándar de la estimación es una medida de cuánto

Deja una respuesta